Tại cuộc họp báo ở Bắc Kinh (thủ đô Trung Quốc) hôm 11.7, các lãnh đạo Intel đã giới thiệu Gaudi2, bộ xử lý không bị Mỹ hạn chế xuất khẩu.

Intel Gaudi2 như đối trọng với bộ xử lý đồ họa (GPU) A100 cao cấp của Nvidia (nhà sản xuất chip có giá trị lớn nhất thế giới), vốn được sử dụng rộng rãi để đào tạo các hệ thống AI.

Trung Quốc chiếm 27% trong tổng doanh thu Intel vào năm 2022, theo báo cáo thường niên mới nhất của công ty.

Intel Gaudi2 nhấn mạnh tầm quan trọng của thị trường Trung Quốc rộng lớn với các nhà cung cấp công nghệ bán dẫn Mỹ, bất chấp các biện pháp kiểm soát xuất khẩu từ chính quyền Biden.

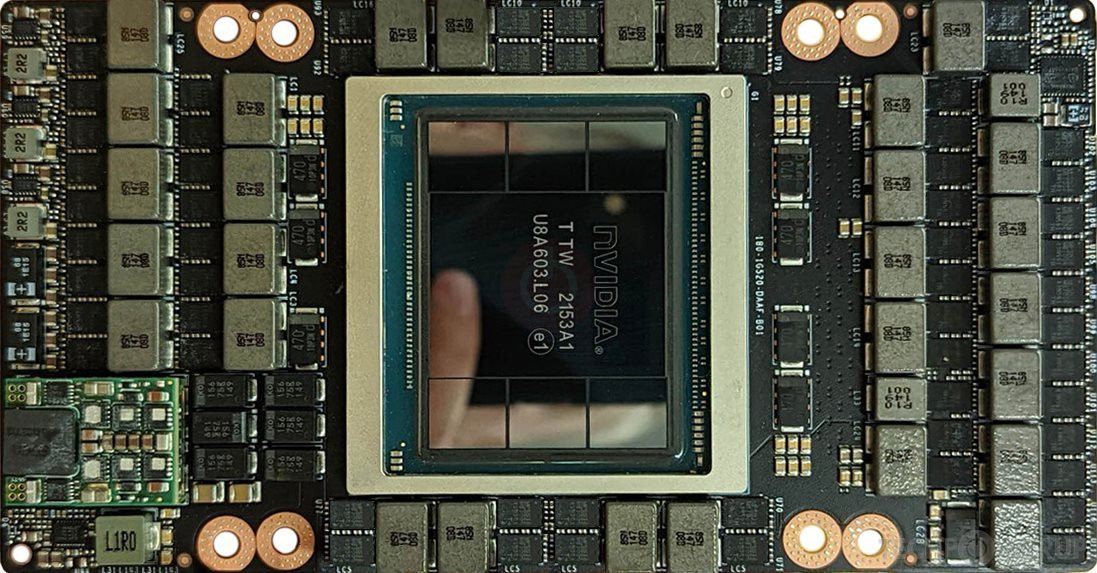

Trước đó, Nvidia nỗ lực bán phiên bản sửa đổi của các dòng GPU chủ lực A100 và H100 cho Trung Quốc để tuân thủ các hạn chế từ Mỹ và duy trì việc cung ứng cho khách hàng ở quốc gia châu Á, nơi các dự án phát triển AI mới nở rộ để tạo ra các dịch vụ tương tự ChatGPT của OpenAI.

Vào tháng 8.2022, Bộ Thương mại Mỹ đã áp đặt lệnh cấm Nvidia và Advanced Micro Devices (AMD) bán một số chip tiên tiến cho Trung Quốc. Nvidia được hướng dẫn ngừng bán GPU A100 và H100, trong khi AMD bị ngăn xuất khẩu chip MI250 sang Trung Quốc. Điều này khiến cho ngành công nghiệp AI của Trung Quốc phải tìm mua nguồn cung hạn chế các loại chip tiên tiến từ Nvidia, công ty gần như độc quyền về GPU được sử dụng để huấn luyện hệ thống AI.

Nhu cầu lớn từ Trung Quốc đã tạo ra một thị trường ngầm buôn lậu các GPU, chẳng hạn Nvidia A100 và H100.

Theo trang web của Nvidia, A100 cung cấp sức mạnh cho các trung tâm dữ liệu hàng đầu thế giới được sử dụng cho AI, phân tích dữ liệu và các ứng dụng điện toán hiệu suất cao.

“Với Intel, nhu cầu tại Trung Quốc củng cố cam kết của công ty cung cấp cho khách hàng một loạt các lựa chọn phần cứng", bà Sandra Rivera, Phó chủ tịch điều hành Intel và cũng là Tổng giám đốc nhóm trung tâm dữ liệu và AI, nói tại buổi họp báo ở Bắc Kinh.

Sandra Rivera cho biết Gaudi2 được thiết kế để giảm rào cản với việc tham gia và nâng cao khả năng của khách hàng "triển khai AI thông qua công nghệ đám mây và điện toán biên đa truy cập, giúp xây dựng tương lai AI của Trung Quốc".

Intelthông báo đang hợp tác với Inspur Group (nhà sản xuất máy chủ trí AI lớn thứ hai trên thế giới, có trụ sở tại tỉnh Sơn Đông, Trung Quốc) để xây dựng các máy mới được trang bị Gaudi2 cho thị trường đại lục.

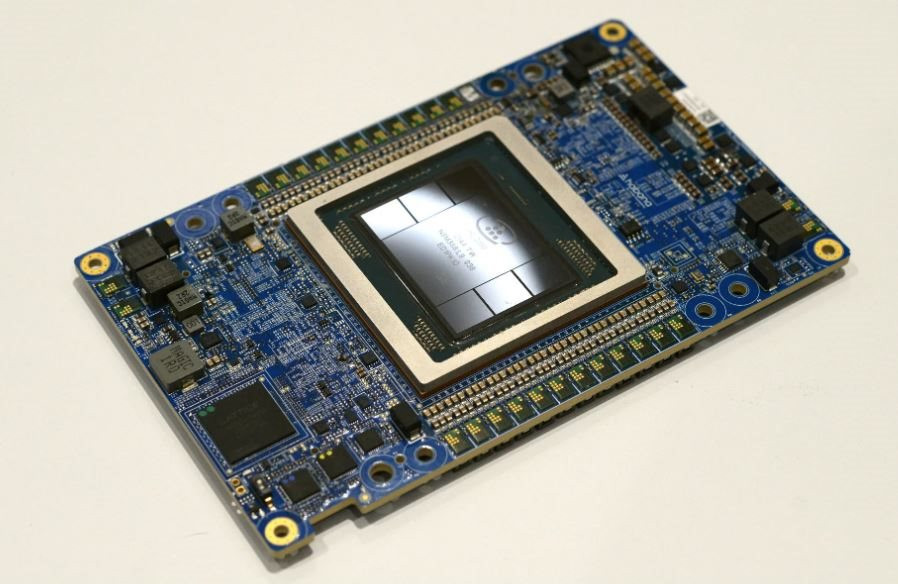

Habana Labs, nhóm trung tâm dữ liệu của Intel tập trung vào các công nghệ bộ xử lý học sâu AI, lần đầu tiên ra mắt Gaudi2 vào tháng 5.2022 tại Mỹ. Habana Labs cho biết hiệu suất xử lý đào tạo của Gaudi2 gấp đôi so với GPU Nvidia A100 80GB cho mô hình thị giác máy tính ResNet-50 và mô hình xử lý ngôn ngữ tự nhiên BERT.

Giải pháp mới nhất của Intel đến vào thời điểm có nhiều khó khăn tiềm ẩn với tham vọng AI của Trung Quốc. Chính phủ Mỹ được cho đang xem xét hạn chế quyền truy cập của các công ty Trung Quốc vào các dịch vụ điện toán đám mây Mỹ, điều này sẽ ngăn Amazon Web Services và Microsoft sử dụng sức mạnh chip AI tiên tiến để mang lại lợi ích cho khách hàng đại lục, theo tờ The Wall Street Journal.

Mỹ được cho cũng đang xem xét một động thái leo thang để đưa GPU A800 đã giảm hiệu suất của Nvidia vào lệnh cấm xuất khẩu, The Wall Street Journal đưa tin tháng trước.

Nvidia H800 bị giảm hiệu suất nhưng vẫn mạnh

Các chuyên gia trong ngành nói với Reuters rằng H800, sản phẩm được Nvidia công bố vào tháng 3, có thể mất thời gian lâu hơn từ 10 - 30% để thực hiện một số tác vụ AI và giá có khả năng đắt gấp đôi chip nhanh nhất của Nvidia tại Mỹ.

Ngay cả những chip Nvidia bị giảm hiệu suất cũng là sự cải tiến cho các công ty Trung Quốc. Tencent, một trong những hãng công nghệ lớn nhất Trung Quốc, ước tính rằng các hệ thống sử dụng Nvidia H800 sẽ giảm hơn một nửa thời gian đào tạo mô hình AI lớn nhất của họ, từ 11 ngày xuống còn 4 ngày.

Một phần chiến lược của chính quyền Biden khi đặt ra các quy định là tránh cho người Trung Quốc bị sốc đến mức bỏ các chip Mỹ hoàn toàn và tăng gấp đôi nỗ lực phát triển chip của chính họ.

"Chính quyền Biden phải vạch ra ranh giới ở đâu đó. Bất cứ nơi nào được vạch ra, họ sẽ gặp phải thách thức là làm thế nào để không gây đảo lộn ngay lập tức, nhưng cũng phải làm suy giảm năng lực của Trung Quốc theo thời gian", theo một giám đốc ngành chip yêu cầu giấu tên.

Các hạn chế xuất khẩu có hai phần.

Thứ nhất là đặt giới hạn cho khả năng tính toán các con số cực kỳ chính xác của chip - biện pháp hạn chế các siêu máy tính có thể được sử dụng trong nghiên cứu quân sự. Các nguồn tin trong ngành công nghiệp chip cho biết đó là một biện pháp hiệu quả. Song, việc tính toán các con số cực kỳ chính xác ít liên quan hơn trong công việc AI như các mô hình ngôn ngữ lớn, trong đó việc chip xử lý khối lượng lớn dữ liệu lại quan trọng hơn.

Nvidia đang bán H800 cho các hãng công nghệ lớn nhất Trung Quốc như Tencent, Alibaba và Baidu để sử dụng trong công việc như vậy, dù vẫn chưa vận chuyển chip này với số lượng lớn.

“Chính phủ không tìm cách gây hại cho cạnh tranh hoặc ngành công nghiệp Mỹ và cho phép các công ty Mỹ cung cấp sản phẩm cho các hoạt động thương mại, chẳng hạn như cung cấp dịch vụ đám mây cho người tiêu dùng”, Nvidia từng tuyên bố và cho biết Trung Quốc là khách hàng quan trọng với công nghệ của Mỹ.

Nhà sản xuất chip giá trị nhất thế giới nói thêm: "Các biện pháp kiểm soát xuất khẩu hồi tháng 10.2022 của Mỹ yêu cầu chúng tôi tạo ra các sản phẩm có khoảng cách ngày càng lớn giữa hai thị trường. Chúng tôi tuân thủ quy định trong khi cung cấp các sản phẩm cạnh tranh nhất có thể ở mỗi thị trường".

Bill Dally, nhà khoa học chính của Nvidia, nói rằng “khoảng cách này sẽ tăng nhanh theo thời gian khi các yêu cầu đào tạo AI tiếp tục tăng gấp đôi sau mỗi 6 đến 12 tháng”.

Giới hạn thứ hai của Mỹ là về tốc độ truyền giữa chip với chip, điều này ảnh hưởng đến AI. Các mô hình đằng sau các công nghệ như ChatGPT quá lớn để vừa với một chip. Thay vào đó, chúng phải được trải rộng trên nhiều chip, thường là hàng ngàn chip cùng lúc, tất cả đều cần giao tiếp với nhau.

Nvidia chưa tiết lộ chi tiết hiệu suất của chip H800 chỉ dành cho Trung Quốc, nhưng một bảng thông số kỹ thuật mà Reuters đã xem cho thấy tốc độ giữa chip với chip là 400 gigabyte/giây, thấp hơn một nửa so với tốc độ tối đa 900 gigabyte/giây của chip Nvidia H100 hàng đầu có sẵn bên ngoài Trung Quốc.

Một số người trong ngành công nghiệp AI tin rằng tốc độ như vậy vẫn còn cao. Naveen Rao, Giám đốc điều hành công ty khởi nghiệp MosaicML (Mỹ) chuyên hỗ trợ các mô hình AI chạy tốt hơn trên phần cứng hạn chế, ước tính hệ thống dùng Nvidia H800 sẽ bị chậm từ 10 - 30%.

"Có nhiều cách để vượt qua những điều này bằng thuật toán. Tôi không thấy đây là một ranh giới trong khoảng thời gian rất dài, chẳng hạn 10 năm", Naveen Rao nói.

Tiền bạc sẽ giải quyết được vấn đề. Chip Nvidia H800 tại Trung Quốc mất gấp đôi thời gian để hoàn thành tác vụ huấn luyện AI so với H100 ở Mỹ, nhưng vẫn có thể hoàn thành công việc.

“Khi đó, bạn phải chi 20 triệu USD thay vì 10 triệu USD để huấn luyện AI. Điều đó có tệ không? Có. Thế nhưng, việc này không phải là vấn đề với Alibaba hay Baidu", một nguồn tin trong ngành cho hay.

Hơn nữa, các nhà nghiên cứu AI đang cố gắng thu gọn các hệ thống khổng lồ mà họ đã xây dựng để cắt giảm chi phí huấn luyện các sản phẩm tương tự ChatGPT và các quy trình khác. Những thứ đó sẽ yêu cầu ít chip hơn, giảm giao tiếp giữa chip với chip và giảm tác động của việc Mỹ giới hạn tốc độ.

Cập nhật tin tức công nghệ mới nhất tại fanpage Công nghệ & Cuộc sống