Người dùng trên toàn thế giới thích thú trò chuyện với chatbot AI này mỗi ngày vì khả năng trả lời lưu loát như người thật của ChatGPT. Tuy nhiên, có một thực tế ít người biết đằng sau mỗi câu trả lời của ChatGPT là một khoản phí không nhỏ mà OpenAI, công ty tạo ra chatbot này, đang phải trả mỗi ngày.

Không giống như các dịch vụ web thông thường, việc vận hành một chatbot AI với khả năng đa tài năng như ChatGPT tốn kém hơn nhiều, chủ yếu là do phí khổng lồ dành cho hạ tầng điện toán đám mây.

Theo các nhà phân tích, nền tảng đám mây Azure của Microsoft đang chạy ChatGPT, giúp OpenAI không phải lo lắng về việc thiết lập phòng máy chủ vật lý hoặc vận hành nó. Tuy nhiên, khi sử dụng nền tảng đám mây này để chạy ChatGPT, họ sẽ phải trả phí cho Microsoft.

Không giống như các dịch vụ web thông thường, việc vận hành một chatbot AI với khả năng đa tài như ChatGPT tốn kém hơn nhiều.

Chi phí cho mỗi câu trả lời của ChatGPT

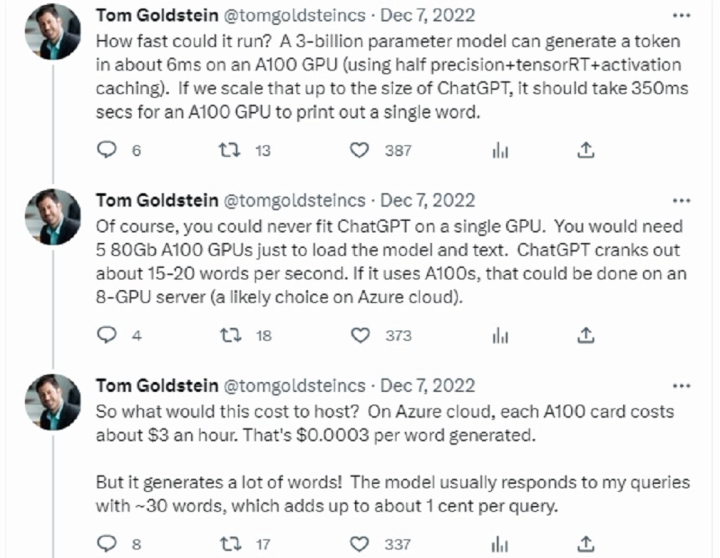

Phân tích của Tom Goldstein, giáo sư về AI, bảo mật và quyền riêng tư tại Đại học Maryland, được hiển thị bên dưới. Ông Goldstein đã thử xác định chi phí mà OpenAI phải trả cho Microsoft đối với mỗi câu trả lời của ChatGPT cho người dùng bằng cách sử dụng kiến thức chuyên môn và hiểu biết của mình.

Trước hết phải nhắc đến mô hình xử lý ngôn ngữ tự nhiên GPT-3 do OpenAI tạo ra để sử dụng làm nền tảng cho ChatGPT. Với 175 tỷ tham số, GPT-3 là mô hình xử lý tiếng Anh tự nhiên lớn thứ hai trên thế giới hiện nay, sau mô hình Swift Transformer của Google. Đây là một con số khổng lồ đối với các mô hình AI hiện đang được sử dụng.

Vậy tốc độ xử lý của nó là gì? Theo ông Goldstein, một mô hình với 3 tỷ tham số chạy trên một GPU Nvidia A100 80GB có thể tạo ra một token trong vòng 6ms (mili giây). Một GPU A100 sẽ mất 350 ms để tạo ra một từ duy nhất với quy mô quy mô 175 tỷ tham số như của ChatGPT.

Tất nhiên, một GPU duy nhất là không đủ để chạy toàn bộ ChatGPT. Chỉ cần 5 GPU A100 để tải toàn bộ mô hình và xử lý văn bản trong đó. Hiện tại, ChatGPT có thể tạo ra khoảng 15-20 từ mỗi giây. Do đó, nếu sử dụng các GPU Nvidia A100, toàn bộ mô hình có thể phải chạy trên máy chủ ảo với 8 GPU này ( đây cũng là một chọn thường thấy trên Azure).

ChatGPT thường có khoảng 30 từ, hoặc trung bình khoảng 1 cent cho mỗi câu trả lời. (Ảnh cắt màn hình Twitter)

Mỗi GPU A100 sẽ tốn khoảng 3 USD mỗi giờ sử dụng với mức giá hiện tại của Microsoft. Điều này có nghĩa là 0,0003 USD cho mỗi từ được tạo ra. Ngược lại, mỗi câu trả lời của ChatGPT thường có khoảng 30 từ, hoặc trung bình khoảng 1 cent mỗi câu trả lời. Con số dường như rất nhỏ so với suy nghĩ của mỗi người.

Tuy nhiên, vấn đề với ChatGPT là kể từ khi ra mắt, lượng người dùng hàng ngày của họ đã tăng chóng mặt. Lượng người dùng hàng ngày của ChatGPT đã vượt mốc 10 triệu vào thời điểm hiện tại - 40 ngày sau khi ra mắt - cột mốc mà Instagram từng phải mất gần một năm để hoàn thành một việc.

ChatGPT sẽ cần xử lý khoảng 50 triệu câu hỏi mỗi ngày, giả sử trung bình mỗi người dùng hỏi 5 câu mỗi ngày. Con số này tương đương với mức phí 500.000 USD mỗi ngày hoặc 15 triệu USD mỗi tháng. Tuy nhiên, khi vẫn còn nhiều người dùng thử ChatGPT trên toàn thế giới, con số này có thể chưa dừng ở đây và sẽ khiến mức phí này tăng lên.

Mặc dù mối quan hệ đối tác với Microsoft có thể mang lại mức phí thấp hơn cho OpenAI, nhưng chắc chắn con số này không hề nhỏ. Mặc dù không cho biết con số chính xác, nhưng trong một cuộc phỏng vấn đầu tháng 12 vừa qua, ông Sam Altman, CEO OpenAI, cũng nói rằng: "Tại một thời điểm nào đó, chi phí điện toán đang tăng lên đến mức đáng kinh ngạc, vì vậy chúng ta phải nghĩ cách kiếm tiền từ nó.

Không những thế, số tiền này lại càng đáng kể hơn đối với một tổ chức đang chìm trong thua lỗ như OpenAI.

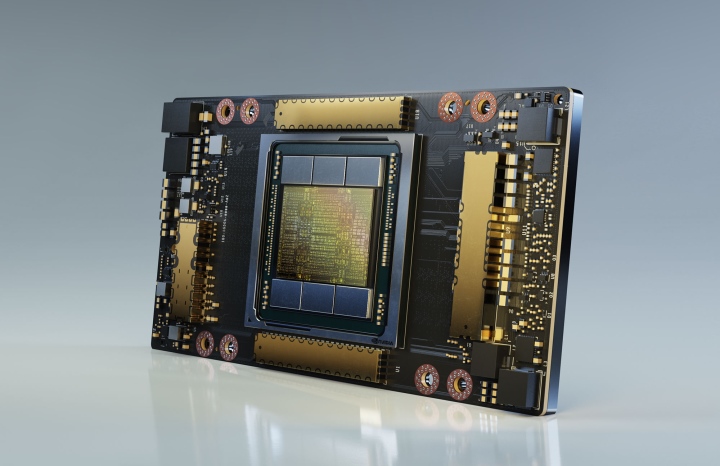

VGA Nvidia A100 80GB, một loại GPU chuyên dụng cho xử lý tác vụ AI của Nvidia, có giá hàng chục nghìn USD mỗi chiếc. (Ảnh internet)

Cơn sốt ChatGPT cứu cánh cho OpenAI

Theo báo cáo từ trang Fortune, Mặc dù không còn là một công ty phi lợi nhuận, OpenAI vẫn tạo ra doanh thu khá khiêm tốn. Mặc dù thực tế là họ tạo ra gần 30 triệu đô la doanh thu hàng năm, nhưng họ đã chi tới 416,45 triệu đô la cho hoạt động tính toán và xử lý dữ liệu, gần 89,31 triệu đô la cho lương nhân viên và khoảng 38,75 triệu đô la cho các chi phí hoạt động khác. OpenAI đã lỗ tổng cộng 544,5 triệu đô la trong năm 2022.

Nếu tính đến chi phí ngày càng tăng của ChatGPT, thì mức thua lỗ này sẽ càng nghiêm trọng hơn. Tuy nhiên, cơn sốt mà ChatGPT đang tạo ra trên toàn cầu đã mang lại cho OpenAI một cứu cánh đúng lúc họ cần: khoản đầu tư 10 tỷ USD đến từ Microsoft và các tổ chức khác. OpenAI cũng đang dự đoán rằng danh tiếng của ChatGPT sẽ lôi kéo thêm khách hàng cho các sản phẩm khác, với dự báo doanh thu 200 triệu USD vào năm 2023 và 1 tỷ USD vào năm 2024.

Quyết định mới đây của tổ chức này là giới thiệu dịch vụ ChatGPT Pro với mức phí thuê bao hàng tháng là 42 USD, điều này được giải thích bởi mức chi phí khổng lồ của dịch vụ ChatGPT và sức ép gia tăng doanh thu của OpenAI. Khách hàng có thể chọn sử dụng dịch vụ khi nhu cầu tăng lên, tốc độ phản hồi của chatbot nhanh hơn và ưu tiên tiếp cận các tính năng mới với phiên bản trả phí.

Bổ ích

Xúc động

Sáng tạo

Độc đáo

Cập nhật tin tức công nghệ mới nhất tại fanpage Công nghệ & Cuộc sống